El salto de la IA al edge deja atrás al almacenamiento tradicional: Lexar estrena un módulo con gran rendimiento, resistente e intercambio en caliente

por Manuel NaranjoLa inteligencia artificial se nos ha ido de la nube. O, mejor dicho, ya no vive solo allí. Cada vez más tareas que antes dependían de grandes centros de datos se están ejecutando directamente en el dispositivo: en el portátil, en el coche, en una cámara profesional o en un robot de almacén. Eso tiene una consecuencia directa de la que se habla menos que de los chips o las GPU: el almacenamiento se ha convertido en uno de los grandes cuellos de botella de la nueva era de la IA en el edge.

Un modelo que genera imágenes, que entiende voz, que analiza vídeo 4K en tiempo real o que fusiona datos de varios sensores no solo necesita potencia de cálculo. Necesita leer y escribir cantidades enormes de datos, muchas veces en bloques muy pequeños y de forma caótica.

A esto se suma un problema de escala. Firmas como Gartner prevén que, en apenas un par de años, más de la mitad de los ordenadores vendidos serán PC con IA capaces de ejecutar modelos de forma local. Eso supone centenares de millones de dispositivos generando y moviendo datos entre sí: del portátil al sobremesa, del robot a la estación de supervisión, del coche al sistema de diagnóstico del taller. El almacenamiento ya no es solo “dónde guardo las cosas”, sino una pieza clave para que toda esa inteligencia distribuida funcione sin atascarse.

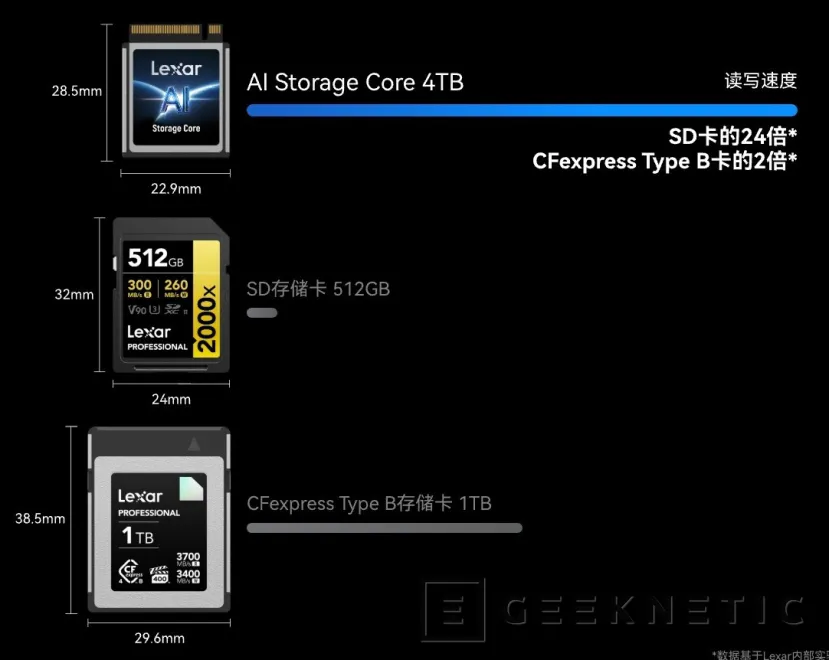

En ese contexto aparecen propuestas como el nuevo núcleo de almacenamiento para IA de Lexar, una especie de “módulo de inteligencia” que intenta responder justamente a esos retos: más ancho de banda, más capacidad de respuesta, más resistencia física y mucha más flexibilidad a la hora de mover sistemas y datos entre máquinas.

El rendimiento ya no va solo de gigabytes por segundo

Cuando se habla de almacenamiento rápido, solemos pensar en cifras de lectura y escritura secuencial, esas que lucen muy bien en la hoja de especificaciones. En IA en el edge, la historia es distinta. Lo que realmente marca la diferencia es cómo se comporta el sistema con operaciones pequeñas, aleatorias y constantes. Cargar un modelo grande, ir consultando pesos, gestionar caches, trabajar con muchas imágenes o fragmentos de audio a la vez… todo eso somete al almacenamiento a un patrón de acceso muy diferente al de un uso “normal”.

El enfoque de Lexar pasa por optimizar precisamente ese escenario: mejorar la gestión de E/S de bloque pequeño y jugar con capas de caché y modos tipo SLC para reducir la latencia en cargas de trabajo como LLM locales, edición de imagen generativa o análisis de vídeo en tiempo real. El resultado, sobre el papel, es un módulo que no solo es capaz de alcanzar altas velocidades, sino de mantenerlas cuando el sistema empieza a bombardearlo con operaciones aleatorias.

IA que no se detiene aunque el entorno sea hostil

El otro gran frente es la fiabilidad. Muchos de los dispositivos que tiran de IA en el edge no viven en un despacho climatizado. Piensa en cámaras montadas en drones, en robots que recorren un almacén, en vehículos con conducción asistida o autónoma circulando en pleno verano o a varios grados bajo cero. Ahí el almacenamiento sufre.

Por eso tiene sentido que este tipo de módulos apuesten por empaquetados integrados y sellados, capaces de soportar agua, polvo y golpes, y de funcionar en rangos de temperatura extremos.

El almacenamiento como pieza extraíble y portátil

La tercera pata del enfoque de Lexar es la flexibilidad. Aquí la idea es tratar el almacenamiento casi como un “cartucho inteligente” que puedes quitar y poner sin apagar el equipo. El diseño intercambiable en caliente permite extraer el módulo mientras el sistema sigue encendido, algo que abre un abanico de usos interesante: desde mover modelos y datos entre distintas estaciones de trabajo hasta actualizar la “inteligencia” de una flota de robots simplemente cambiando el módulo.

Cinco escenarios que resumen hacia dónde va todo esto

Aunque la tecnología es la misma, los casos de uso son muy diferentes:

- PC con IA: aquí manda la versatilidad. Cargar modelos, gestionar proyectos de IA generativa, trabajar con edición de vídeo o foto acelerada por IA.

- Juegos con IA: no se trata solo de tiempos de carga reducidos. Los títulos que empiezan a incorporar personajes y sistemas impulsados por modelos requieren mover muchos datos en segundo plano mientras todo fluye a 60, 120 o más FPS. Altas IOPS y buena lectura aleatoria se traducen en menos tirones y una experiencia más estable.

- Cámaras con IA: captura continua en 4K u 8K, reconocimiento de escenas, seguimiento de sujetos, filtros inteligentes… Todo en tiempo real y, a menudo, en exteriores.

- Conducción con IA: un coche actual con sistemas avanzados de asistencia o conducción semi-autónoma puede estar recibiendo datos de varias cámaras, radares, sensores ultrasónicos y, en el futuro, LiDAR. Todo eso se tiene que almacenar y procesar sin descanso.

- Robótica con IA: quizá el caso que mejor resume la filosofía de estos módulos. Robots de almacén, brazos industriales, vehículos autónomos de reparto… todos ellos operan con restricciones de espacio, con movimientos bruscos y, a menudo, en turnos casi ininterrumpidos.

Propuestas como el núcleo de almacenamiento para IA de Lexar son una muestra de hacia dónde va la industria: módulos pensados desde el principio para este nuevo tipo de cargas, para estos escenarios físicos tan distintos y para un futuro en el que los datos y los sistemas ya no vivirán atados a una sola máquina.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!