Los modelos de lenguaje en local llegan al móvil

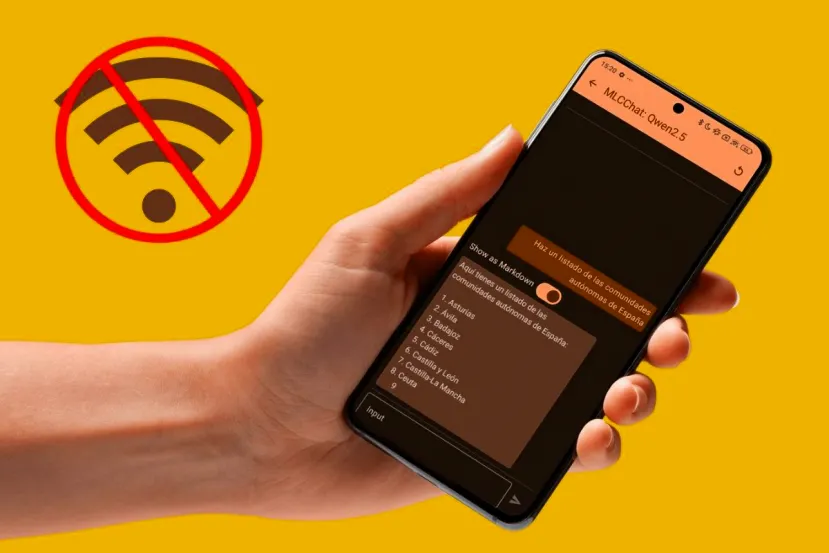

En esta guía quiero explicarte cuáles son los pasos que debes seguir para ejecutar modelos de lenguaje en local directamente en tu móvil Android. Y es que el mundo de la inteligencia artificial está cambiando rápidamente. Desde hace tiempo, existen un montón de herramientas para "jugar" con diferentes modelos directamente en nuestro equipo. De hecho, ya te expliqué cómo usar Ollama para interactuar con la IA desde la consola de comandos, cómo instalar DeepSeek-R1 en tu PC con esta misma herramienta y cómo tener varios chatbots de IA sin conexión.

Todas estas guías tienen un denominador común: están pensadas para ser llevadas a término en un equipo de escritorio. Ahora, lo que te propongo aquí es bastante distinto. Descubre cuáles son los pasos que debes seguir para instalar y ejecutar modelos de lenguaje en tu móvil Android. También te hablo un poco sobre los requisitos y el dispositivo que he utilizado para llevar a cabo todas las pruebas. ¡No te lo pierdas!

Requisitos para ejecutar modelos de lenguaje en Android

Actualmente, la ejecución de modelos de lenguaje en Android es posible, aunque con algunos matices. Si te esperabas tener algo tan potente como las versiones completas de GPT-4o o DeepSeek-R1, te recomiendo que lo vayas olvidando. Actualmente, no existe ningún móvil que sea capaz de lidiar con estos grandes modelos de lenguaje. Por eso, todos ellos se ejecutan en centros de datos, es decir, en la nube.

Ahora bien, eso no quiere decir que no haya LLM más pequeños que sí que funcionen bien en un móvil Android. De hecho, se espera que en el futuro tanto Apple como Google terminen integrando modelos de lenguaje más pequeños en los dispositivos para no tener que recurrir a servidores externos. Los modelos que se pueden ejecutar en un móvil tienen entre 1,5 y 8 billones de parámetros. Estas versiones no están pensadas para tareas más básicas o mecánicas, como generar contenido simple o procesar textos.

No existe ningún requisito específico para ejecutar modelos de lenguaje en un móvil Android. Sin embargo, tal y como pasa con los PC, cuanto más potente sea el hardware del dispositivo, modelos más grandes podrán ser ejecutados y con mayor solvencia. En mi caso, aún teniendo dispositivos más potentes para hacer pruebas, me he decantado por un modelo de hace 4 años.

Concretamente, las aplicaciones que te muestro en esta guía las he probado con un Xiaomi 11T, con una SoC octa-core a 3 GHz y 8 GB de RAM. De este modo, tendrás como referencia un dispositivo que, aunque es totalmente funcional hoy en día, está muy lejos de los todopoderosos teléfonos de gama alta de este año, como el Samsung S25 Ultra. A partir de mi experiencia, vas a poder determinar si tu dispositivo podrá lidiar con los modelos más potentes o no.

MLCChat, una app para instalar varios LLM

MLCChat es una aplicación que vas a poder descargar de forma gratuita y que proporciona acceso a los siguientes modelos de lenguaje:

- Phi 3.5 mini

- Qwen 5.1 1.5B

- Gemma 2 2B

- Llama 3.2 3B

- Mistral 7B

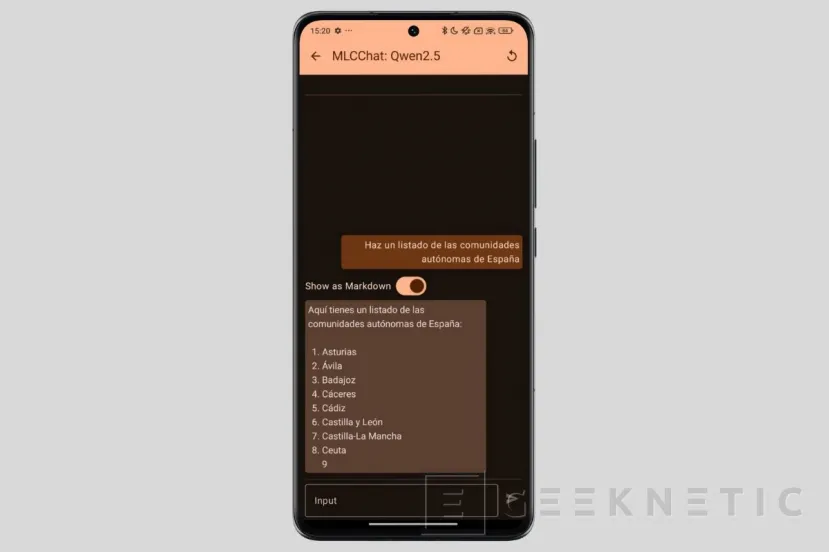

Como ves, son todos ellos modelos bastante pequeños. El más grande en cuestión de parámetros es el de Mistral. Para empezar, lo único que debes hacer es descargar el APK desde el enlace que te he dejado arriba e instalar MLCChat. Una vez hayas terminado, abre la aplicación y haz lo siguiente:

- Presiona en el botón de descarga que hay junto a cada modelo, tal y como te indico en la imagen superior. Cuando termine la descarga, pulsa en el botón del bocadillo para empezar a chatear.

- En la parte inferior de la pantalla verás un mensaje que dice "Initialize". Eso quiere decir que la app está cargando el modelo. Cuando termine, verás otro aviso donde dice "Ready to chat". Ahora puedes empezar a chatear.

- Todas las respuestas que aparecen en pantalla se han generado con los recursos de tu dispositivo, sin necesidad de conectarse a ningún servidor externo. Puedes comprobarlo activando el modo avión.

En mi caso, he podido trastear un poco con el modelo Qwen2, que es uno de los más pequeños. El rendimiento es suficientemente bueno. Por el contrario, con modelos más grandes, como Llama 3.2 3B, el dispositivo se ha saturado y no ha sido capaz de resolver las peticiones.

También puedes usar LM Playground

Otra herramienta que funciona de forma parecida, pero que en este caso está disponible en la Play Store, es LM Playground. Es otra propuesta de código abierto que te va a permitir descargar y ejecutar varios modelos de lenguaje de manera totalmente local. Una vez la tengas en tu móvil, sigue estos pasos:

- Presiona en el botón Select model que verás en la parte superior de la pantalla.

- Luego, elige el modelo que quieres ejecutar. En la siguiente captura puedes ver el listado completo de modelos.

- Espera a que se termine de descargar.

- Cuando lo tengas, chatea con él. Como en todos los casos, el rendimiento dependerá del modelo que elijas y de la potencia de tu dispositivo.

Con LM Playground he utilizado varios modelos. Primero, he probado con un modelo mediano. Concretamente, he instalado Mistral 7B. Los resultados han sido bastante sorprendentes: aunque las respuestas no se componían muy rápido, lo cierto es que ha sido completamente funcional. Con modelos más pequeños, como Llama3.2 1B, la experiencia ha sido muy buena en cuanto a rendimiento. Lamentablemente, las respuestas son bastante más imprecisas.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!