MSI AI Edge apuesta por la IA en local con un sobremesa de 4 litros y hasta 96 GB de memoria unificada para la GPU

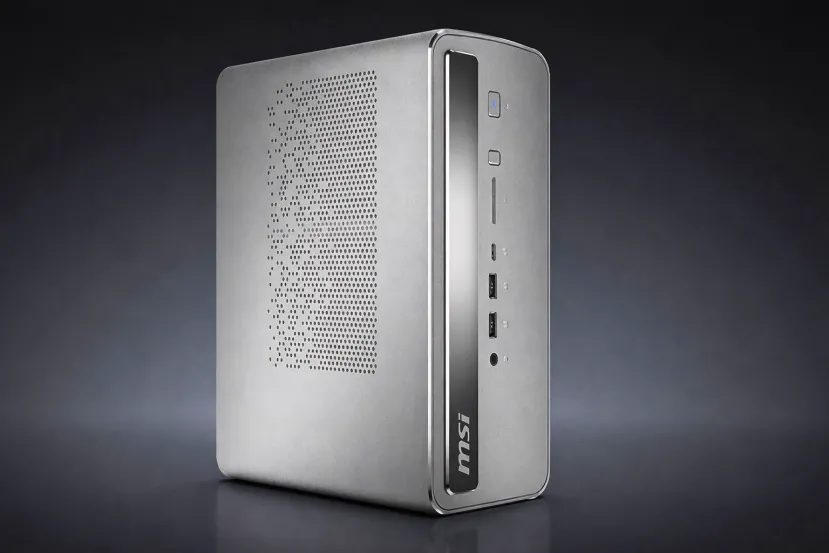

por Manuel Naranjo CES 2026En el último año, la IA se ha vuelto cotidiana: resumen de reuniones, búsqueda en documentos y asistentes para programar o redactar. El problema es que la experiencia suele depender de la nube. Cuando todo pasa por servidores externos, aparecen tres frenos claros: latencia, costes recurrentes y la incomodidad de subir información sensible. Por eso el MSI AI Edge presentado en el CES 2026 llama la atención: un sobremesa compacto, de 4 litros, diseñado para ejecutar inferencia de IA en el propio equipo.

MSI lo enmarca en el concepto edge AI y se apoya en una combinación que, sobre el papel, ataca el gran cuello de botella de la IA en PC: la memoria disponible para la parte gráfica. En vez de depender de una tarjeta dedicada con VRAM limitada, el AI Edge gira alrededor de la plataforma Strix Halo de AMD y su enfoque de memoria unificada.

Un chasis pequeño que apuesta por estabilidad, no por picos

El AI Edge busca ser compacto de verdad. MSI lo describe como un sistema de 4 litros con fuente de alimentación integrada, evitando el típico bloque externo. Aun así, lo importante es el rendimiento sostenido. La inferencia de IA puede ser una carga continua, y en un chasis pequeño la temperatura decide cuánto rinde de verdad.

Para mantener estabilidad, MSI menciona su solución térmica Glacier Armor, con disipación reforzada en componentes clave. La idea es que el equipo no tenga que recortar frecuencias en cuanto acumula calor, algo que se nota mucho más que una diferencia pequeña en especificaciones cuando llevas rato trabajando.

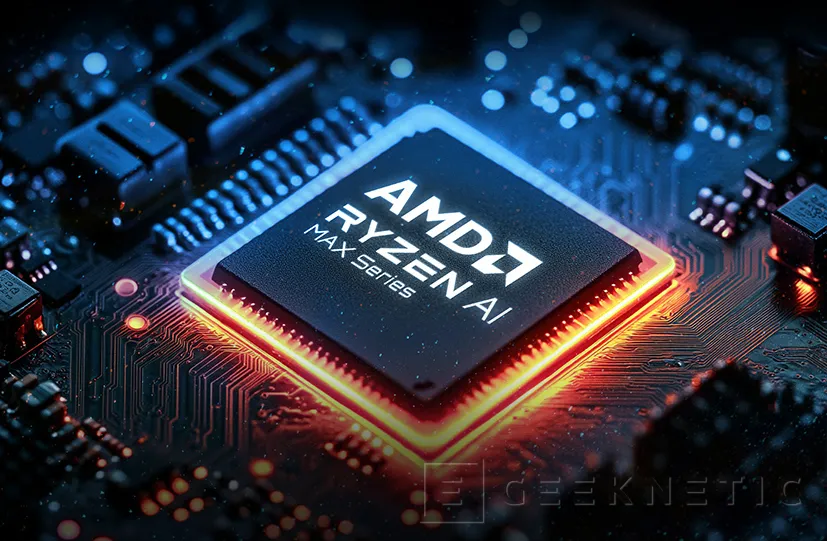

Ryzen AI Max+ 395: TOPS totales y una NPU XDNA 2 con peso real

El corazón del equipo es el AMD Ryzen AI Max+ 395, dentro de la familia Ryzen AI Max+ 300. MSI cifra el rendimiento total para IA en hasta 126 TOPS, sumando CPU, GPU integrada y NPU. Dentro de ese conjunto, la NPU XDNA 2 aporta hasta 50 TOPS teóricos.

Este reparto importa porque permite elegir dónde se ejecuta cada parte del trabajo. Hay tareas que encajan bien en una NPU por eficiencia, otras que tiran de GPU por potencia y otras que se resuelven mejor en CPU. La promesa aquí no es solo potencia bruta, sino una plataforma unificada donde puedes repartir cargas sin depender siempre de una gráfica dedicada.

Memoria unificada: hasta 128 GB y 96 GB asignables a la GPU

El rasgo que define el AI Edge es la memoria. MSI indica que el sistema puede incorporar hasta 128 GB de memoria LPDDR5X 8000 integrada, bajo un esquema de memoria unificada. Y añade un dato clave: hasta 96 GB pueden asignarse dinámicamente a la GPU integrada, basada en RDNA 3.5 con 40 unidades de cómputo.

Esto va directo al problema más común al ejecutar modelos grandes en un PC convencional: la VRAM. Puedes tener mucha RAM, pero si tu GPU se queda en 8 o 12 GB de VRAM, el modelo choca con un muro y toca recortar tamaño o asumir un rendimiento irregular. Con decenas de gigas asignables, el margen cambia de escala y la máquina se vuelve más flexible para inferencia local.

MSI afirma que el equipo puede mover modelos de lenguaje de hasta 120.000 millones de parámetros y alcanzar una salida de 15 tokens por segundo. Son cifras de referencia, pero ayudan a entender el objetivo: que esto no sea una demostración puntual, sino una herramienta capaz de manejar modelos grandes con un ritmo utilizable.

Windows o Linux y flujos con RAG para trabajar con tus datos

Otro detalle práctico es que el AI Edge está pensado para poder funcionar con Windows o Linux. En un equipo orientado a edge AI, esa dualidad encaja: Linux sigue siendo el hábitat natural de muchos stacks de IA, mientras que Windows es clave en productividad y software profesional.

MSI también habla de una aplicación local enfocada a productividad y menciona la integración de RAG (Retrieval Augmented Generation): combinar un modelo con una capa de búsqueda sobre tus propios documentos para responder con contexto real. En vez de pedirle al modelo que improvise, el sistema consulta archivos locales y construye respuestas con esa información.

MSI intenta que el AI Edge no quede encasillado como ordenador solo para IA. Por eso menciona que puede ofrecer una experiencia en juegos comparable a una GeForce RTX 4060. No es una equivalencia exacta de pruebas, pero sí un mensaje sobre el músculo de la iGPU de Strix Halo y su intención de servir como sobremesa generalista.

El mensaje de fondo es claro: parte de la IA vuelve al dispositivo. Eso reduce latencia, evita depender de servicios y refuerza el control sobre datos sensibles. A falta de conocer precio y disponibilidad, MSI ya ha definido una receta: 4 litros, plataforma potente de AMD, memoria unificada muy generosa y foco en inferencia local, con margen para usos generales.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!