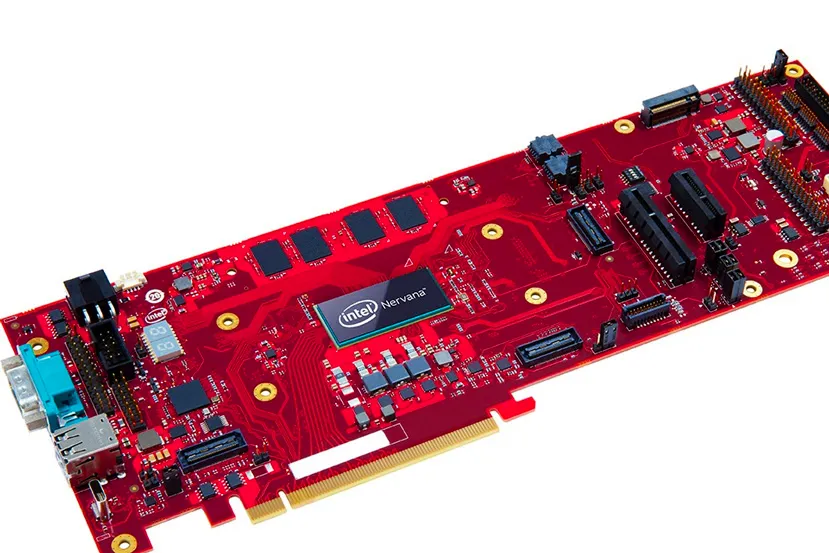

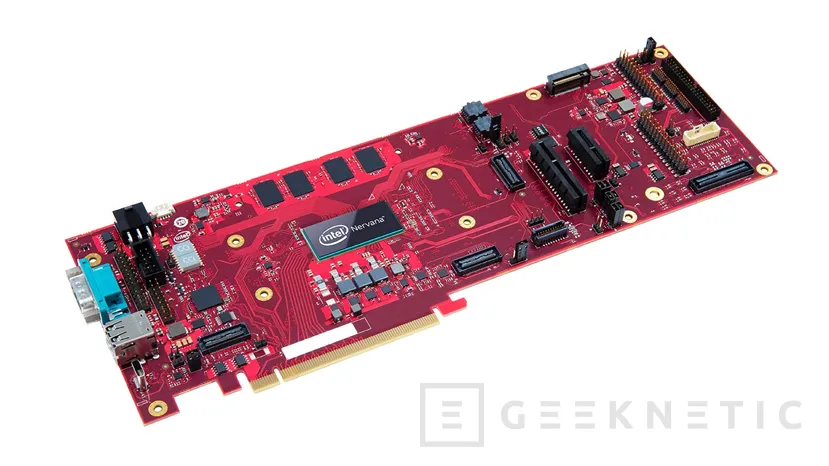

Intel integra procesadores Ice Lake de 10 nm en aceleradores para Inteligencia Artificial en formato M.2.

por Jordi Bercial 2Intel ha anunciado en el IDC sus Nervana Neural Network Processor for Inference, o Nervana NNP-I, el cual se presenta como un procesador Ice Lake a 10 nanómetros modificado para tareas de inferencia montado en un PCB diseñado para encajar en un slot M.2., normalmente utilizado para sistemas de almacenamiento NVMe.

Intel ha eliminado algunas porciones innecesarias de estos procesadores como serían los núcleos de las iGPU u otros componentes asociados para hacer sitio a los aceleradores de IA. La idea detrás de estos procesadores modificados es que las tareas de inferencia requieren de menos potencia de computo que las de entrenamiento de redes neuronales, de forma que se pueden montar estas unidades en servidores para realizar la inferencia en estos módulos de forma externa.

Esto trae varias ventajas, dado que si bien es obvio que se reduce la carga en el sistema principal, también se reduce en gran medida la comunicación necesaria entre los componentes, algo que puede ralentizar las cargas al introducir interrupciones y movimiento de datos, algo de lo que se encarga el propio Nervana NNP-I al incorporar su propio PCH y toda su batería de características conseguidas mediante la combinación de núcleos x86 y núcleos IA que le permite trabajar con casi cualquier lenguaje de IA como PyTorch o TensorFlow.

Si bien el bus PCI-e 3.0 x4 podría parecer un cuello de botella en algunas situaciones, Intel asegura que han testeado el acelerador con cargas de trabajo de análisis de video y no ha encontrado ningún problema, por lo que se supone que este ancho de banda es suficiente. Asimismo, el uso de un bus PCI-E asegura que podemos instalar tantos aceleradores Nervana como queramos y sea posible en un mismo servidor, dado que es compatible con los sistemas ya distribuidos por los centros de datos, además de ser también compatible con risers PCI-Express de cuatro slots de capacidad.

Por ahora Intel no ha dado cifras de rendimiento que demuestren las ventajas de estos módulos de inferencia en conjunción con procesadores Xeon para el proceso de entrenamiento de redes neuronales, por lo que solo queda esperar a que la compañía muestre dichos datos para evaluar las ventajas de este producto.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!