¡GEEKNETIC CUMPLE 20 AÑOS! 2 DÉCADAS DE NOVEDADES EN TECNOLOGÍA

por Mikel Aguirre Actualizado: 25/11/2024 15Geeknetic Está de Celebración

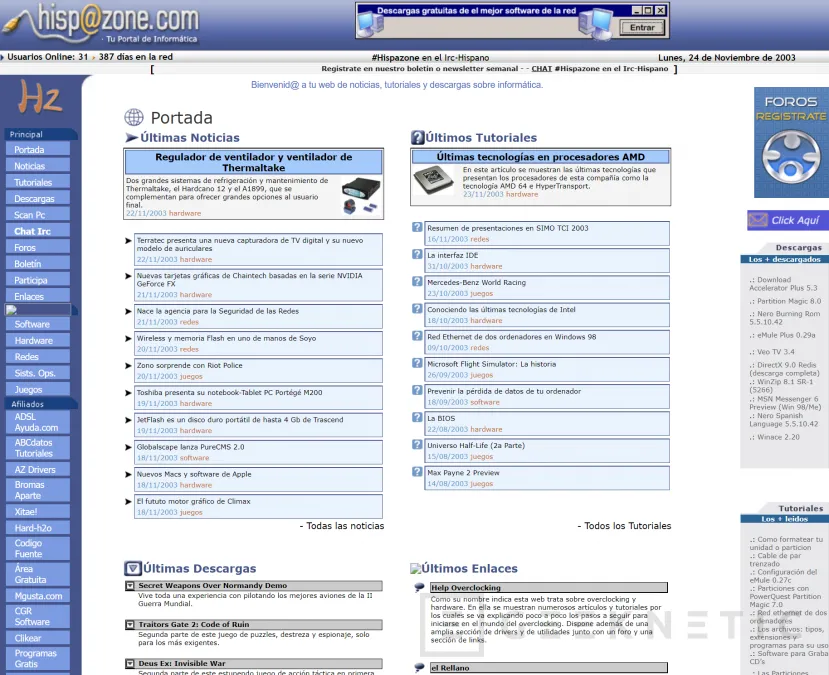

Hoy 2 de noviembre de 2022 se cumplen 20 años desde que nació este sitio web. El nombre en sus inicios era HispaZone, pero lo rebautizamos como GEEKNETIC hace exactamente 6 años.

En estas dos décadas hemos visto de todo en tecnología, el nacimiento de Facebook y YouTube, el resurgimiento de Apple con sus Macbooks y sus iPhones, la absorción de ATI por parte de AMD, la revolución que supusieron los SSDs y otros tantos hitos más de la tecnología que hemos relatado en forma de artículos, noticias, guías y reviews a través de este sitio web.

En este artículo, vengo a traeros un poco de nostalgia a aquellos que nos seguís desde hace años, y a los recién llegados mostraros un poco de lo que era el mundo tecnológico años atrás desde los ojos de una publicación como la nuestra.

No olvides que con motivo de nuestro 20 aniversario hemos organizado un concurso enorme con 30 premios en total que suman más de 5.500 Euros de valor, productos que repartiremos entre múltiples participantes.

HispaZone (hoy Geeknetic) y la Tecnología en 2002

Echando a andar la web

En aquella época no existía Wordpress y tanto yo como algunos de los compañeros que iniciaron este proyecto conmigo tuvimos que aprender a programar y a diseñar desde cero y desarrollar la web durante aquel verano de 2002. El proyecto fue tan duro y largo que no fue hasta el 2 de noviembre que pudo ver la luz.

Exactamente hoy hace 20 años, con la mayoría de edad recién alcanzada, me encontraba delante de mi ordenador, con pantalla de tubo, dando los últimos retoques a la programación del sitio web antes de subir la versión definitiva por FTP al hosting. Como es habitual en la mayoría de adolescentes, mi domicilio era la casa de mis padres, que en todo momento me dieron un gran apoyo y ayuda tanto moral como económica para sacarlo adelante y sin los cuales Geeknetic no existiría.

Mi dormitorio era el “Headquarters”, centro de mando, o sede central de la web, básicamente porque siendo hijo único era el lugar donde estaba el único PC que había en casa, con su flamante conexión a internet por ADSL de 128 Kbps. Al otro lado del cobre estaba mi amigo Pedro Jelicz, cofundador de la web y diseñador de la misma, desde su casa, esperando el gran momento en que tendríamos la web operativa. Igual que él, un puñado de compañeros que colaboraron en nuestros inicios.

Tan pronto finalicé los últimos cambios, los subí, ¡y listo! Teníamos nuestra propia web, un portal sobre tecnología. Al principio nos centramos en educar con guías y en publicar noticias sobre informática. Ya teníamos unos cuantos artículos preparados para el día del lanzamiento. Es por esto que hay artículos en Geeknetic que tienen una fecha anterior al 2 de noviembre de 2002:

El IRC en aquel momento era un sistema de comunicación tremendamente usado y lugar de encuentro para aquellos que hacíamos un uso extenso de internet y buscábamos comunicarnos con gente de forma informal.

En España la red IRC por excelencia era el IRC-Hispano, en la cual teníamos nuestro propio canal, bajo el nombre HispaZone. La red no tiene tanto público como en su día debido a que se hicieron populares otros sistemas como MSN Messenger, Skype, y posteriormente Facebook, Whatsapp, Twitter y Discord entre otros. Hoy en día el IRC-Hispano se ha reconvertido en Chat-Hispano, y aunque se presenta de forma distinta, sigue usando el mismo sistema IRC.

¿Qué se cocía en la tecnología en esa época?

En cuanto a conectividad, lo habitual era el ADSL, aunque ya empezábamos a hablar de fibra óptica. El email no ha cambiado tanto desde entonces, de hecho, en aquella época ya se hablaba de las enormes cantidades de spam que llegaban, tal y como dábamos cuenta en esta noticia.

En aquella época usábamos Internet Explorer o Netscape como navegador. Google Chrome no existía y el navegador libre Mozilla, precursor del Mozzilla Firefox, empezaba a tener sus primeras versiones estables.

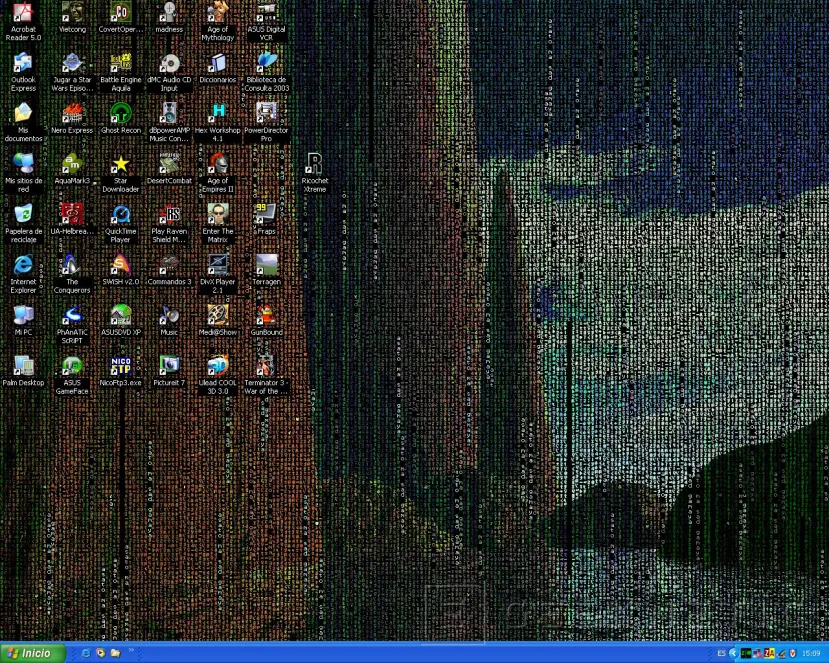

El sistema operativo de moda era Windows XP, aunque muchos usuarios lo usaban a regañadientes. Por aquella época Apple no era tan popular en nuestro país, excepto para los que ya iban con iPods. Esto dejaba la lucha entre Windows y Linux, aunque unos pocos también barrían hacia el sistema operativo BSD.

En cuanto a hardware, Intel y AMD tenían una lucha bastante ajetreada. Intel tenía sus Pentium 4 (Northwood) y AMD tenía sus Athlon XP (Barton). Fue aquella época cuando vimos el nacimiento del primer procesador de 64 bits para uso doméstico: El AMD Athlon 64. Poco después llegaron las primeras CPUs multinúcleo; los Athlon X2 y los Core de Intel.

Lo de los múltiples núcleos y los múltiples hilos (como el hyperthreading de Intel) ya lo vimos en aquella época como una gran revolución. Lo que desconocíamos es que al software le fuera a costar tanto sacar provecho de los múltiples núcleos y aún a día de hoy podemos poner en duda su completo aprovechamiento, especialmente en juegos.

En portátiles, vimos el nacimiento de la CPU de bajo consumo con la gama Centrino de Intel. A partir de ese momento podías usar el portátil durante unas pocas horas sin conectarlo a la red eléctrica y disfrutar de una verdadera experiencia portátil. Curiosamente, la filosofía de arquitectura de CPU de Centrino, que priorizaba el rendimiento por vatio, fue trasladada posteriormente a los sobremesas en los primeros Intel Core que gozaban de un magnífico rendimiento. Este fue un movimiento de gran éxito para Intel, y marcó el principio del fin del éxito de AMD en aquella época.

El iPhone y los smartphones no habían nacido aún. En aquella época la mayoría íbamos con móviles Nokia basados en sistema operativo Symbian, y cuando ibas en transporte público aprovechabas para jugar al juego de la serpiente. Por supuesto, casi nadie tenía internet en el móvil, y nos comunicábamos a base de SMS y en ocasiones con las famosas llamadas perdidas. No obstante, el famoso teléfono de Matrix causó cierto furor en los medios, y nosotros también nos hicimos eco de ello.

En tarjetas gráficas, las GeForce FX 5800 y FX 5900 de NVIDIA eran la gran promesa, aunque no estuvo carente de polémica, debido a los problemas térmicos que sufrían. Aunque dichos problemas fueron subsanados, permitieron a ATI ganar considerable terreno con su gama Radeon 9000.

En aquella época NVIDIA no solo era conocida por hacer chips gráficos, sino también por hacer chipsets de placas base, y muy bien considerados además.

Las pantallas planas se hicieron populares en portátiles, ya que era impensable ponerles una pantalla de tubo y con ello poco a poco fue ganando terreno también en sobremesa. No obstante su alto precio hizo que muchos tardáramos en hacer la transición.

En almacenamiento extraíble el disquete empezaba a desaparecer, incluso la misma Dell anunció que se deshacía de ello en beneficio de otros formatos como el CD y el DVD. En aquella época era impensable comprar un PC sin que tuviera una regrabadora de DVD y todos acumulábamos tubos y tubos de CDs y DVDs grabados y vírgenes listos para usar. El código fuente de este sitio web de hecho lo llevábamos de un PC a otro usando un DVD de estos.

En audio de bolsillo, todavía no era posible escuchar música en tu móvil, pero había una nueva tendencia que estaba pegando fuerte: los MP3. Nuestra primera review de hardware llegó en 2003 y fue precisamente un MP3, el Creative Nomad Muvo NX.

Poco a poco empezamos a hacer reviews de todo aquello que caía en nuestras manos:

- Palm PC Tungsten

- Punto de Acceso Conceptronic

- Tarjeta de sonido externa de TerraTec

- Hasta hicimos una comparativa de Joysticks Logitech

Poco nos imaginábamos de cómo evolucionaría la tecnología.

La Tecnología del 2005 al 2010

Aunque parezca difícil de creer, en aquella época los eSports ya eran toda una sensación y había incluso quien podía permitirse vivir de ello. Fue el caso del famoso jugador profesional conocido como Fatal1ty, ganador a nivel mundial de competiciones de Quake, Call of Duty, Counter Strike y Doom entre otros. Aparte de las ganancias a través de ganar competiciones, registró su nombre de usuario y cedió los derechos del nombre a marcas a cambio de royalties. Por ese motivo hemos visto tantos productos que llevan su nombre, como esta tarjeta de sonido de Creative que analizamos en 2006.

Esta época fue la que vio el nacimiento y expansión de las redes sociales modernas como Facebook, Twitter y LinkedIn, que llegaron a todo con gran rapidez y calaron mucho también en nuestro país. A finales de la década vivimos la llegada Whatsapp, que se cargó por completo los servicios de sms de muchos países, en beneficio de los planes de internet móvil.

Precisamente, Apple lanzo su primer iPhone en 2007, y aunque el smartphone como tal ya existía desde antes, sí que marcó una fuerte tendencia en el mercado que supuso toda una revolución en el mercado de móviles, acelerando la expansión en masa de los smartphones y la transición a 3G. Fue precisamente gracias a apps como whatsapp, lo que hizo que hasta tu abuela, que no había tocado un ordenador en su vida, tuviera un smartphone con internet.

En periféricos el gaming empezaba a ser cada vez más importante, y gracias a ello nacieron los teclados G de Logitech, siendo el G15 uno de los ejemplos más prominentes. Aunque los teclados mecánicos existen desde hace muchísimo, la tendencia en aquel momento eran los interruptores de membrana.

En ratones, el mecanismo de bola quedaba ya en el olvido y lo que estaba de moda eran los ratones con sensor láser. Razer ya empezaba a pegar fuerte en aquella época, a juzgar por esta comparativa que publicamos en 2006. Como habréis podido ver, el modelo de Razer ya venía con LEDs.

Logitech trató de revolucionar el mercado de ratones con un concepto llamado MX Air, que consistía básicamente en que movías el ratón en el aire y con eso movías el puntero. Tuvimos la suerte de probarlo y nos pareció una solución fantástica. No obstante, es evidente que si sigues usando el ratón encima de la alfombrilla a día de hoy es porque este tipo de solución no acabó de cuajar. La razón es obvia, si tienes que estar horas usando el PC, quieres poder apoyar el brazo mientras usas el ratón, lo cual ya te lo permiten los ratones convencionales.

En portátiles se produjo un cambio de paradigma con el Eee PC de ASUS, del cual tuvimos exclusiva mundial aquí en GEEKNETIC. De repente podías comprarte un portátil funcional y perfectamente útil por menos de 300 euros. La primera unidad que probamos estaba basado en Linux, pero las versiones en Windows no tardaron en llegar. Para nutrir esta nueva generación de portátiles pequeños y baratos, Intel lanzó una gama de CPUs llamada Atom, que además tenían muy bajo consumo. Pudimos comprobarlo en el MSI Wind PC que analizamos posteriormente, que era la competencia al Eee PC. A este tipo de portátiles los empezaron a llamar “Netbooks” y aunque poco queda ya de ellos hoy en día, fueron un exitazo en su momento.

Fue una época de gran innovación en portátiles. La nueva gama Core 2 Duo con nombre en clave “Merom” permitieron a fabricantes como ASUS experimentar con nuevos conceptos y gamas. En este artículo englobando las soluciones de ASUS con estas CPUs dimos cuenta de uno de los primeros híbridos 2 en 1 que combinaban el concepto de Tablet con el de portátil.

Otra de las novedades de la época fueron los primeros portátiles gaming. Aquí en Geeknetic tuvimos la suerte de ser uno de los primeros en probar los G1 y G2 de ASUS, nuestro redactor, Jav, quedó gratamente sorprendido. En aquella época, la distancia en rendimiento entre portátiles gaming y sobremesas gaming era tremenda, pero aun así tuvieron una gran acogida.

En CPUs Intel avanzó a pasos agigantados evolucionando su gama Intel Core. Fue en aquella época en que Intel hizo el cambio de nomenclatura hacia Core i7, Core i5 y Core i3, con sus fantásticas CPUs Nehalem. Intel iba tomando una ventaja cada vez más superior a AMD, que aun así no dejo de sacar productos, como el Phenom 9600 Black Edition.

La eficiencia empezó a ser un factor muy determinante. Gigabyte fue uno de los principales fabricantes de placas base que apostó de lleno, desarrollando un sistema llamado DES especializado en el ahorro energético de sus placas, con distintas fases de alimentación. No obstante, la lucha empezó a ser descabellada, las marcas se enzarzaron a competir entre ellas por ver cuál conseguía meterle más fases de alimentación a sus placas, que acabó por ser un despropósito innecesario que solo servía en su mayoría para marketing. Así es como vimos en 2009, placas con hasta 24 fases de alimentación para el procesador.

En gráficos nacía una nueva promesa. Ageia había creado un chip llamado PhysX que calculaba las físicas de los mundos 3D, de forma que los desarrolladores podían ahora hacer juegos en que puedes romper muros, lanzar objetos y este chip lo calculaba y permitía mostrarlo en tiempo real. No es que antes no fuera posible, sino que requería de demasiada potencia si se tenía que ejecutar en la CPU o en la gráfica. Este chip específico permitía que rompieras un muro y que pudieras ver la trayectoria de todos sus trozos en tiempo real en la pantalla, perfectamente representado como si fuera la vida real.

En tarjetas gráficas NVIDIA siguió con su trayectoria de innovación. Uno de los mejores productos fue la GeForce 9600 GT, sucesora de la 8600GT, que calidad precio era genial.

No obstante, lo que verdaderamente causó un antes y un después en la industria fue la compra de ATI por parte de AMD. Gracias a ello pudieron crear un híbrido entre CPU y GPU que llamaron APU y que siguen haciendo hasta el día de hoy. Como bien sabes, AMD siguió adelante con sus GPUs Radeon, y siguen innovando con ello generación tras generación hasta nuestros días. Uno de los productos más destacados poco después de la compra de ATI fue la todopoderosa Radeon 3870X2 que combinaba 2 GPUs en una misma tarjeta gráfica. No mucho después AMD decidió deshacerse de la marca ATI, haciendo que toda la gama Radeon formara parte de la marca AMD.

Estas tarjetas gráficas estaban pensadas además para poder correr juegos en las nuevas resoluciones de pantalla apaisada que estaban cogiendo fuerza, 1280x720px y 1920x1080px. El uso de estas resoluciones se convirtió en un gran reclamo de marketing, es por ello que las bautizaron como HD (Alta Definicón) y FullHD (Alta Definición Total) respectivamente. Así se inició la transición en los PCs desde las pantallas de 4:3 a pantallas de 16:9. Había aun así quien se atrevía a probar con formatos un poco más amplios como este monitor BenQ que analizamos en 2006, que tenía un formato de 16:10

En 2007 Microsoft lanzó Windows Vista. La transición no fue particularmente buena y sin duda consumía muchos más recursos que Windows XP. La llegada de Windows Vista fue visto por muchos como una involución, creando muchos detractores. Para cuando llegó Windows 7 todos éramos muy escépticos, sin embargo, éste si que demostró ser una auténtica revolución. Windows 7 era un sistema operativo muy refinado mucho mejor optimizado que sus predecesores y hacía que su uso fuera tremendamente más cómodo y rápido, incluso en el mismo PC.

Apple por su parte usaba ya CPUs Intel en la mayoría de sus ordenadores Mac, ya que el proveedor de CPUs anterior (PowerPC) no era capaz de hacer sombra a las todopoderosas CPUs Core de Intel. Esto hacía que fuera inevitable pensar que los Mac eran esencialmente un PC, por mucho que Apple tratara de indicar que era un ordenador totalmente distinto. No hay nada como tener un laboratorio de pruebas para demostrarlo, en este artículo vimos cómo era posible instalar MacOS en un PC y además hacerle overclocking para que funcione con mucho más rendimiento que el que se podía tener en un iMac de la época.

Lo mismo hicimos con el MSI Wind PC, al que pudimos instalar MacOS, demostrando que los Macbooks también eran, en cuanto a su hardware se refiere, PCs.

En este tiempo la expansión de internet de banda ancha se multiplicó y esto supuso que ya fuera posible visualizar vídeos en tiempo real, provocando que sitios web como Youtube cobraran gran importancia. Google no tardó en tirarse a la piscina para comprarlo por una millonada. Esto también facilitó que empezaran a proliferar servicios de contenido bajo demanda como Spotify o Netflix y tiendas de juegos sin soporte físico como Steam. Además, los Pen Drive, o unidades de memoria flash de almacenamiento externo habían cobrado un considerable protagonismo. Todo ello contribuyó a que las ventas de DVDs y CDs vírgenes cayera en picado, y con ello cada vez eran menos los que instalaban una regrabadora de CDs y DVDs en sus ordenadores.

Al final, resultó que el único elemento mecánico que quedaba en el PC eran los discos duros. No obstante, no les quedaba mucho tiempo, estaban empezando a llegar unas nuevas unidades que usaban el mismo sistema almacenamiento que los Pen Drive, memorias NAND, pero pensadas para conectarse dentro del PC como almacenamiento principal. Se trata de los SSD.

El primer SSD que analizamos en GEEKNETIC fue el Intel SSD X25-M de 80 GB, allá por el 2008. El salto al SSD fue la gran revolución de la época, y el mayor salto tecnológico que hemos visto nunca en estos 20 años. Cambiar a un SSD suponía una ventaja mucho más grande que renovar con cualquier CPU o tarjeta gráfica nueva, como pasar de una bicicleta a un Fórmula 1. Cogías un ordenador cualquiera de la época, le ponías un SSD y migrabas al mismo el sistema operativo y los programas, y el PC volaba, era como si fuera otro.

La Tecnología desde el 2010 al 2015

Siguiendo con los SSD, su éxito era evidente. Al principio los SSD para uso doméstico tan solo funcionaban por bus SATA. Hubo marcas que apostaron muy fuerte por los SSD y enseguida el rendimiento creció tanto que alcanzó el máximo que da de sí el bus SATA 3, un gran ejemplo fue el OCZ Vertex 2 que analizamos, que superaba todo lo que habíamos visto hasta el momento.

Alcanzado el máximo del bus SATA 3 con los SSD, era evidente que había un cuello de botella importante. No obstante, aquello no impidió que todo el mundo comprara SSDs, tanto para PCs nuevos como para actualizar los existentes. En 2013 publicábamos esta guía para aprender a migrar a un SSD.

La solución al cuello de botella estaba en el uso del bus PCI Express a través de los slots PCI Express de las placas base de la época, que ya se usaban para tarjetas gráficas y otros componentes. Empezaron a salir tarjetas de almacenamiento como el Revodrive de OCZ. El problema es que estas soluciones no estaban al alcance de todo el mundo y los SSD por SATA ya proporcionaban un salto más que considerable.

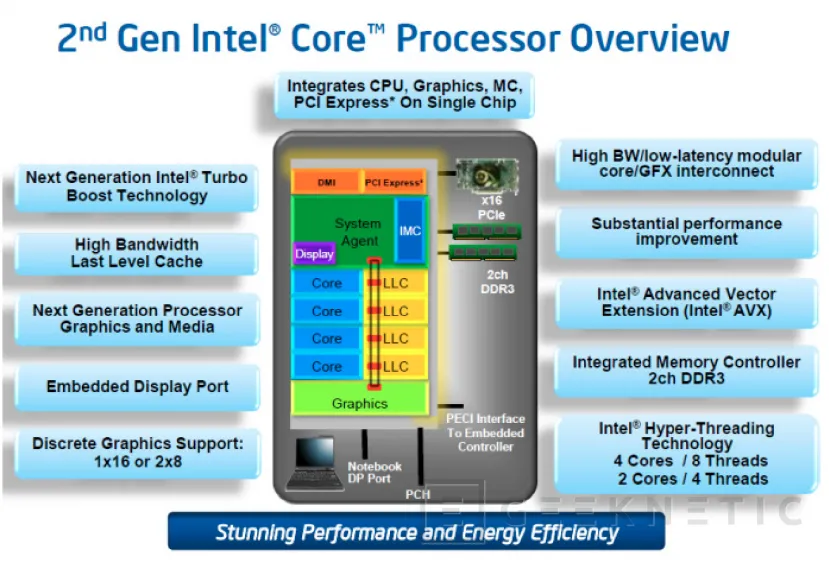

En CPUs Intel dominaba con soltura, mejorando e innovando generación tras generación. Los Sandy Bridge, lanzados en 2011, causaron una gran sensación y contribuyeron a que AMD quedara mucho más rezagada. Ni siquiera el Phenom 2 X4 980 Black Edition, que era uno de sus buques insignia, era capaz de hacer sombra a un Core i5 normalito de Intel.

En gráficos la lucha entre NVIDIA y AMD era tremenda. Ambas marcas fueron sacando productos y dando saltos de rendimiento generación tras generación, tanto con productos de una sola GPU como con tarjetas gráficas que incorporaban 2 GPUs. El problema es que la escalabilidad no era equivalente, igual que con el SLI y el Crossfire, poniendo 2 GPUs no obtenías el doble de rendimiento, por lo que tanto el mercado como las marcas fueron perdiendo interés.

Esto último se hizo patente con uno de los chips gráficos más importantes de la época: el GeForce GTX Titan X de NVIDIA, basado en arquitectura Maxwell. Una bestia de chip gráfico capaz de producir el rendimiento de las tarjetas gráficas de 2 GPUs, con una única GPU.

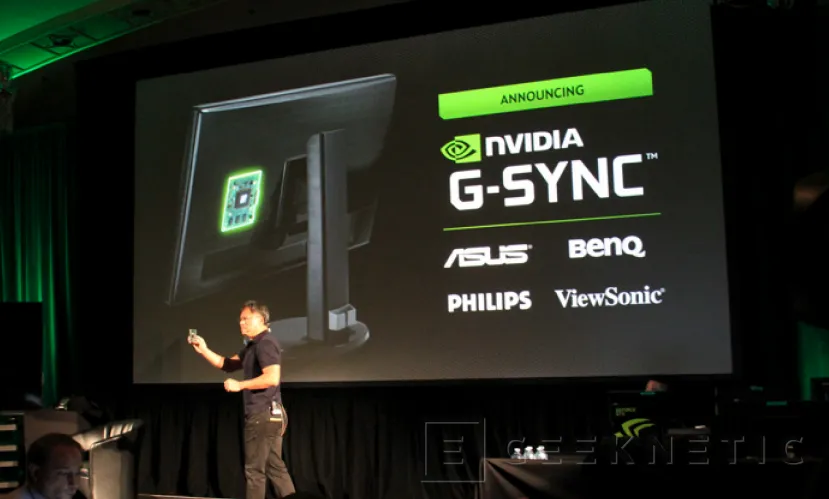

En 2013 NVIDIA nos llevó a Montreal, Canadá, sin decirnos lo que presentarían allí. Nos llevamos una grata sorpresa cuando desvelaron una nueva tecnología llamada G-SYNC, que hacía que fuera la tarjeta gráfica y no el monitor quien gobernara la frecuencia de escaneo. De esta forma ya no era necesaria la sincronización vertical o V-SYNC, ya que el monitor mostraba cada cuadro cuando la gráfica se lo mandaba, prometiendo eliminar el stuttering por completo.

Una de las razones por las que nos gustó tanto esta tecnología es que ahora podías bajar de los 60FPS, necesario si no podías comprarte una gráfica de las más caras, y tener sincronización con la pantalla, lo cual técnicamente debería beneficiar a los usuarios con menos poder adquisitivo. El problema es que NVIDIA en un principio hizo que esta tecnología fuera propietaria, limitándose no solo a sus tarjetas gráficas, sino también a través de los monitores. Desarrollaron un módulo que el fabricante del monitor tenía que integrar como requisito a poder usar esta tecnología. Esto hizo que solo monitores de muy alta gama como este ASUS ROG SWIFT acabaran siendo compatibles, haciendo que los usuarios con menor poder adquisitivo no pudieran acceder a ello.

La alternativa de AMD al G-SYNC llegaría un par de meses después. Lo llamaron FreeSync, en clara referencia a su naturalidad libre. De hecho, FreeSync pasó a formar parte del estándar VESA, lo que permitió que la sincronización adaptativa llegara por defecto a miles de monitores de todas las marcas y rangos de precio.

Otra de las tendencias en esa época fue la transición a las resoluciones de ultra alta definición, a las que popularmente se llamó 4K, por ser 4 veces superior a la alta definición. Los primeros monitores 4K que probamos fueron un ASUS 4K de 28 pulgadas y este ACER XB280HK de 28 pulgadas que fue el primero en combinar 4K y GSYNC en un mismo producto.

No obstante, todas estas cosas no hacen sombra a lo que estaba a punto de ocurrir. Se acercaba una grandísima y tremenda innovación tecnológica que fue el antes y el después, dejándonos a todos con la boca abierta de cómo contribuía a hacer el PC tremendamente más potente, hasta límites insospechados. Estoy hablando de … ¡los leds RGB en componentes y periféricos!

El párrafo anterior es broma obviamente, pero viene a reflejar un poco cual fue nuestro punto de vista en aquel momento. Aunque ya teníamos iluminación LED en cada componente y periférico que te pudieras imaginar, éstos eran de un único color. La “innovación” fue empezar a usar LEDs RGB configurables, y ahora podías tener el PC iluminado con los colores que quisieras. El Tesoro Lobera Supreme fue el primer teclado con LEDs RGB que probamos. La ironía en el párrafo anterior se debe a que durante aquella época las marcas se centraron en innovar casi exclusivamente en este campo.

Cajas con RGB, ventiladores con RGB, refrigeraciones con RGB, ratones con RGB, teclados con RGB y hasta monitores, que de por sí emitían luz, ahora también tenían lucecitas LED RGB en su carcasa. Las placas base se renovaron para incluir sistemas que gestionaran todos estos leds, y cada marca sacó su sistema: ASUS Aura, MSI Mystic Light, Gigabyte RGB Fusion, etc.

Para una publicación de tecnología como la nuestra, que buscamos que nos sorprendan con innovaciones técnicas que aporten al rendimiento y usabilidades del PC, fue una época un tanto complicada. Ibas por ferias y por eventos de presentación y la novedad, una y otra vez, era que le habían puesto RGB a un producto que antes no lo tenía, o que habían añadido un nuevo efecto de iluminación RGB diferente al anterior. Nos sentíamos como si no estuviéramos aportando información interesante y útil a nuestros los lectores.

No significa que no fuera importante, las marcas nos decían que la realidad es que el RGB contribuía positivamente a las ventas. Esto hizo que su expansión, por mucho que nos pesara, fuera inevitable. Gracias a eso hoy en día reconocemos más fácilmente un producto pensado para gaming, cuando éste tiene iluminación RGB.

Todas las marcas se sumaron al carro del RGB, salvo una excepción: Noctua. Esta reconocida marca austríaca decidió pasar por alto esta moda y seguir innovando y mejorando sus ventiladores manteniendo su fidelidad al color de braga-faja que les caracterizaba, como el usado en esta review de su NH-D15S. Tal vez gracias a que dedicaron su esfuerzo al rendimiento y prestaciones en lugar de al RGB, Noctua sigue siendo a día de hoy uno de los máximos referentes mundiales en ventiladores.

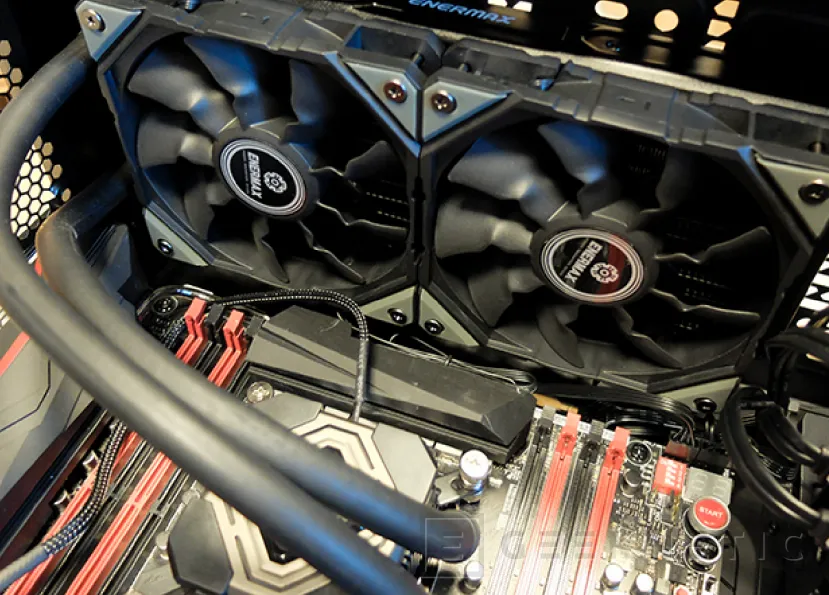

La refrigeración líquida estaba en plena expansión en aquella época, gracias a la aparición en masa de kits premontados y sellados que hacían su instalación tremendamente más fácil y rápida. Tal vez no daban el mismo rendimiento que las refrigeraciones líquidas personalizadas, pero daban más rendimiento que la refrigeración por aire sin tener que andar cortando el tubo, llenando el circuito con el líquido refrigerante. Abrías la caja, anclabas el bloque de agua al socket, el radiador a la caja y listo. Uno de los grandes protagonistas de aquella época, fue la refrigeración Enermax Liqmax II que probamos aquí, el favorito de muchos.

Otra de las promesas de la época era la realidad virtual o VR. Durante todo el 2014 publicamos sin parar sobre las Oculus Rift, que parecía que iban a revolucionar el gaming para siempre. Aún faltaba algo de tiempo para poder venderse al público general. Acabamos aquella época soñando con que pronto tendríamos experiencias como las de Matrix.

La Tecnología desde el 2015 al 2020

En 2015 el almacenamiento con chips NAND continuaba evolucionando. En portátiles se extendía un nuevo puerto llamado M.2 que era posible usarse para todo tipo de dispositivos, desde almacenamiento a chips conectividad. Su formato reducido permitió hacer portátiles más finos.

Además, el puerto M.2 era mucho más versátil que otros especialmente dedicados al almacenamiento ya que podían ir por interfaz SATA o PCI Express.

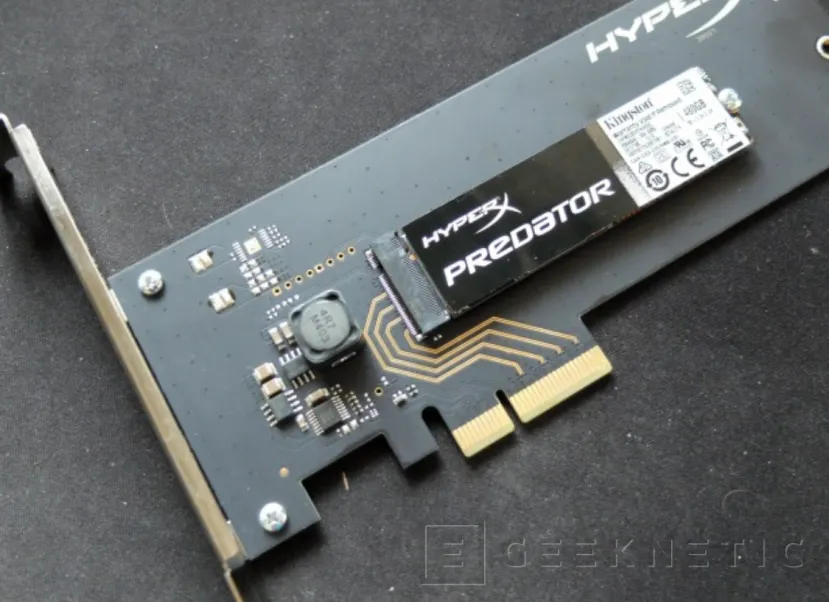

Con ello llegaron las unidades M.2 NVMe que integraban su propia controladora de memoria NAND y que suponía una mejora sustancial en la velocidad de acceso a los datos. El primero de estos que probamos fue el Kingston Predator 480GB que traía una tarjeta PCI Express en que insertarlo si no disponías de puerto M.2.

Este puerto resultó ser tan efectivo que también empezó a popularizarse en sobremesas gracias a su implantación en la placas base que empezaron a salir a partir de aquel momento.

En 2016 acudí al último Intel IDF (Intel Developer Forum) en San Francisco. Era el evento principal del año para Intel, que además de juntar a desarrolladores y marcas de tecnología, también aprovechaban para sacar producto y mostrar en qué estaba trabajando el gigante azul de los chips. No obstante, no es precisamente por Intel por quien recordamos aquel evento.

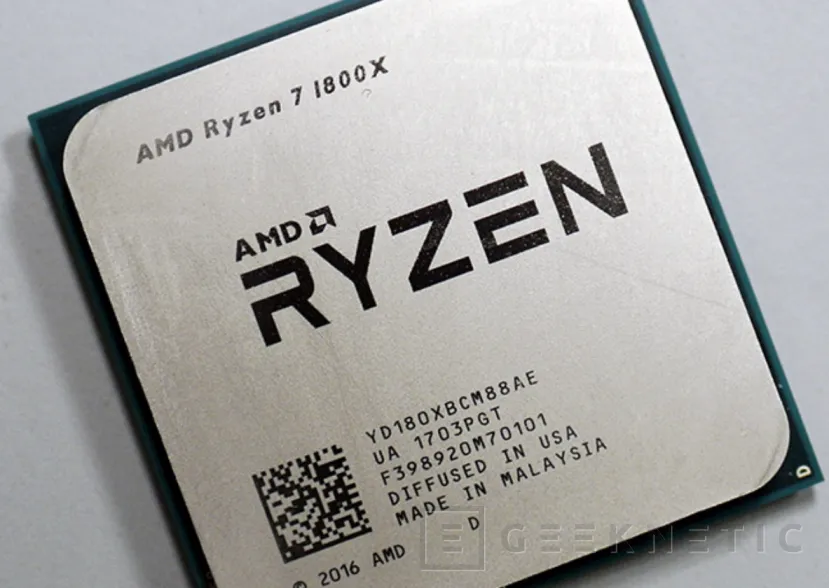

AMD aprovechó que había periodistas de todo el mundo invitados por Intel en San Francisco esos días para engatusarnos hacia un hotel cercano, debíamos ser unos 50 periodistas. Una vez allí Lisa Su, que llevaba poco liderando AMD, nos sorprendió a todos con lo que nos mostró: la arquitectura Zen y un prototipo funcionando que batía en rendimiento a todo lo que tenía Intel en ese momento.

Parecía increíble, meses atrás vaticinábamos la bancarrota de la empresa, y de repente ahí estaban con una arquitectura de CPUs extraordinaria listos para plantar cara, tras años de rezagados, a la todopoderosa Intel.

Este fue el comienzo de una era complicada para Intel; su prometido proceso de 10nm se quedó estancado, y productos que tenían que haber salido en este proceso de fabricación lo hacían a 14nm uno tras otro. Todo esto al tiempo que AMD continuaba lanzando CPUs tremendamente potentes generación tras generación, comiendo una cuota de mercado muy sustancial a Intel. Precisamente uno de los productos más espectaculares fue el primero de los Threadrippers, el AMD Threadripper 1950X, que otorgaba 16 núcleos y 32 de potencia desenfrenada que podías instalar en un PC de sobremesa.

Resulta irónico que el comienzo de la “mala racha” de Intel diera comienzo precisamente en su evento IDF con la presentación de Zen por parte de AMD. El tema de los 10nm de Intel fue para largo; tanto aquí en Geeknetic, como en otros medios, estábamos esperando a ver cuando llegarían noticias de un nuevo retraso en la llegada de los 10nm a los sobremesa. La cosa acabó costando el puesto al CEO de Intel (por mucho que de puertas a fuera dijeran que era confraternizar con una empleada) y acabaron la década sin una figura robusta que liderara la compañía y sin estrenar los 10nm en sobremesas.

En GPUs sin embargo, no corrían los mejores tiempos para AMD. Nos llevamos una gran decepción cuando nos desvelaron que las tarjetas gráficas conocidas como “Polaris” eran en realidad de gama media y tendríamos que esperar mucho más hasta poder ver algo que pudiera darle respuesta a lo mejor de NVIDIA, que en ese momento eran las GTX 1080.

Y es que las GeForce GTX 1080 de NVIDIA, basadas en arquitectura Pascal, fueron un salto de rendimiento gráfico muy importante. Uno de los puntos fuertes precisamente era su capacidad de ser usadas en juegos de realidad virtual, que consumían muchos más recursos que los juegos convencionales.

Las Oculus por fin llegaron al mercado y otras marcas como HTC y Valve se apresuraron para desarrollar productos que le hicieran competencia. El VR se puso muy de moda, pero no para el consumidor, sino para las marcas de hardware, que no paraban de bombardearnos con que sus PCs o componentes estaban preparados para el VR. Zotac de hecho se atrevió a crear un PC mochila pensado para la realidad virtual.

Por fortuna o por desgracia el VR nunca acabó de despegar, en beneficio de los monitores más modernos que ahora estaban dotados de HDR y de paneles curvos, como el fabuloso Acer Predator X35, que incorporaba ambas cosas. Como era de esperar, el Adaptive Sync o AMD Freesync se popularizó tanto que NVIDIA acabó por hacer su G-SYNC compatible, relegando aquellos módulos de G-SYNC a un puñado de monitores de altísima gama.

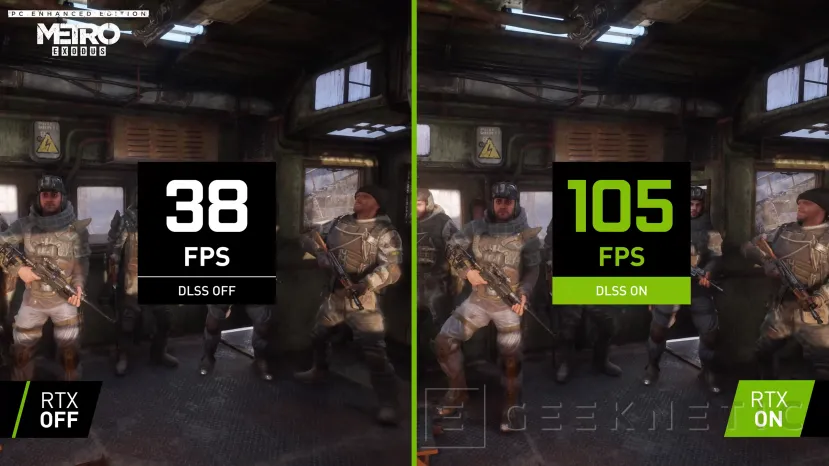

A final de la década, la sorpresa en gráficos vino por parte de NVIDIA. En agosto de 2018 introdujeron su primera gama de chips gráficos GeForce RTX, diseñados para RayTracing e Inteligencia Artificial. Debido al alto consumo de recursos que requería el RayTracing, NVIDIA inventó el DLSS, un sistema que permite renderizar cada fotograma a una resolución inferior para luego ser escalado a la resolución del monitor con inteligencia artificial para que pareciera que había sido renderizado a esa resolución.

El resultado de esto es tan bueno que ha permitido crear juegos mucho más exigentes de lo que las tarjetas gráficas son capaces de soportar, haciendo posible que éstas puedan moverlos con soltura. Por mucho que le pese a NVIDIA, el DLSS, que fue creado para solucionar el alto coste de renderizar el raytracing, ha acabado siendo mucho más popular e importante. El consumidor ha demostrado que prefiere jugar con soltura aunque no tenga la mejor gráfica, que tener un juego más realista con RayTracing. Sea como fuere NVIDIA estaba a la vanguardia de la innovación y AMD, una vez más, no tenía nada convincente con qué competir.

No obstante, nada supera, una vez más la "grandiosa" novedad que nos tenían preparada algunos fabricantes para el Computex 2018. Ahora los productos no solo eran RGB, ¡sino que habían evolucionado para convertirse en "ARGB"! Es decir, lo mismo, pero con efectos configurables. Ahora puedes hacer una ola luminescente con el PC, imitar una máquina de hacer palomitas o hacerlo que parezca Las Vegas en Navidad.

Es broma obvbiamente, no me malinterpretes, no me parece mal que se añadan efectos visuales a los PCs, yo mismo tengo RGB en mi PC (desactivado eso sí), es simplemente que resulta bastante triste para un periodista de tecnología ver que lo único a destacar en un producto nuevo es eso. Sigamos.

En redes de telefonía móvil vimos como el 4G se extendía a diestro y siniestro por toda la geografía. Excelentes noticias para los que hacemos un uso extensivo del móvil. Mientras tanto, Qualcomm no dejaba de demostrarnos las proezas de su tecnología 5G, por la que habían apostado fuertemente para las siguientes generaciones de smartphones.

En el segmento de smartphones de alta gama precisamente una marca que tuvo un protagonismo especial en esta época fue Huawei, que llegó a convertirse en la 2ª marca de smartphones más importante del mundo.

Geeknetic acudió a toda presentación mundial de móviles Huawei desde su flamante P9 hasta aquel fatídico Mate 30. Fatídico porque fue el primer buque insignia de Huawei que no pudo estar conectado a los servicios de Google, al menos de forma oficial, debido a la lista de exclusión en la que el gobierno de Donald Trump introdujo al gigante chino. Aunque la compañía sigue innovando y ofreciendo excelentes soluciones en otros mercados, las cosas para Huawei no fueron iguales desde entonces.

Esta época fue también particularmente importante para nosotros. A principios de 2015 introdujimos el nuevo diseño de la web, muy parecido al de ahora, pero menos evolucionado, dejando atrás el viejo diseño que llevábamos arrastrando durante 13 años.

Ese mismo año formamos parte, entonces aún bajo el nombre HispaZone, de la creación de la European Hardware Association. Ese mismo mes de junio, como miembros de dicha asociación, fuimos anfitriones en Taipéi de la primera gala de entrega de premios European Hardware Awards, que a día de hoy se han convertido en uno de los premios más prestigiosos a los que una marca de tecnología puede aspirar. En el presente seguimos siendo uno de los miembros activos en la asociación y en todo lo relacionado con la misma.

Poco después, el 2 de noviembre de 2016, coincidiendo con nuestro 14 aniversario, cambiamos el nombre de HispaZone a Geeknetic. En este artículo expliqué en su día los motivos. 2 años después vio la luz uno de nuestros proyectos. Lanzábamos nuestra propia calculadora para fuentes de alimentación, que es usada por muchísima gente cada día. Puedes verla aquí.

La tecnología en el presente

Los últimos años han sido de locos en el sector. Por un lado, hemos tenido una pandemia que ha llevado a buena parte de la población activa a trabajar desde sus domicilios y a los niños a recibir su enseñanza de forma virtual. Con ello las ventas de PCs se dispararon de forma desmesurada.

Esto se ha sumado a una demanda tremenda de chips por parte de todos los sectores, incluyendo automoción, drones, smartphones y por supuesto nuevas tarjetas gráficas. Tarjetas gráficas que han sido usadas masivamente para minar. Todo ello dando lugar a una escasez de chips sin precedentes y precios desorbitados.

Para colmo a mitad de pandemia surgieron numerosos problemas de suministro, provocando roturas de stock que paralizó fábricas de coches y la llegada de producto de muchas marcas, por no hablar del agravante que supuso el atasco del barco mercante Evergreen en el canal de Suez.

De todas formas, todo esto no ha impedido que las marcas de tecnología innoven.

Una de las cosas más destacables, al menos en gráficos, es el lanzamiento de FSR por parte de AMD. Es cierto que es una alternativa al DLSS de NVIDIA, pero está hecho de forma que funcione en cualquier tarjeta gráfica, vieja o nueva, de AMD, de NVIDIA o de quien se aventure a hacer un chip gráfico de PC. Hasta funciona con los chips gráficos integrados con los chips de Intel, que han podido correr juegos que hasta ese momento no podían.

NVIDIA ha continuado lanzando generaciones de arquitecturas y chips gráficos pensados para el raytracing, siendo el más reciente el GeForce RTX 4090. Es en el momento de escribir este artículo, el chip gráfico más potente que hemos probado nunca.

AMD por su parte, lanzó la gama Radeon RX 6000, basada en RDNA2, que consiguió unos resultados bastante decentes, siendo capaz de situar la Radeon RX 6900XT por encima de la RTX 3070 de NVIDIA. La siguiente generación de AMD está al caer, y al poco de publicar este artículo es cuando tendrá lugar una presentación virtual de AMD que promete desvelarnos cosas de RDNA3.

Y aquí es donde llega Intel al mercado de tarjetas gráficas. Tras años trabajando en ello, este año hemos podido ver al fin chips gráficos dedicados del gigante azul. Todo comienzo en un segmento nuevo es difícil, por mucho que seas Intel y tengas hordas de ingenieros trabajando a destajo siendo tutelados por el mismísimo Raja Koduri. Lo cierto es que lo único que podemos afirmar de los chips gráficos de Intel es que efectivamente han hecho chips gráficos dedicados que funcionan y se pueden usar. Punto. Si queremos rendimiento tope de gama por el momento en Intel no lo encontraremos. Tendremos que esperar a futuras generaciones para que nos sorprendan.

Intel sin embargo, sí que ha introducido una gran innovación en CPUs recientemente. En 2021 presentaron las CPUs Intel de 12ª generación, que tenían como gran novedad el hecho de combinar, por primera vez en arquitectura x86, núcleos de distinto tipo, siguiendo el patrón big.LITTLE que durante tantos años ha dominado el mercado de móviles. Ahora acaban de renovar su arquitectura siguiendo el mismo concepto y acabamos de publicar nuestra review de un Core i9-13900K.

En cuanto a Geeknetic, el gran cambio estos últimos años ha sido que durante la pandemia dejaron de existir los eventos de presentación en persona y las ferias de tecnología presenciales. Tuvimos que dar cuenta de las novedades única y exclusivamente de forma virtual, sin ver los productos en estands, sin poder echar una caña con ingenieros de marcas tecnológicas para poder sonsacarle cosas de sus productos y sin poder explorar nuevas startups interesantes por los pasillos de las ferias. La excepción han sido las reviews, que siempre proceden de productos que hemos recibido físicamente en nuestro laboratorio y hemos podido llevarlas a cabo con normalidad.

No obstante, parece ser que vamos dejando ya los confinamientos y las restricciones de viaje en el pasado. Este año 2022 estamos volviendo a viajar a eventos y ferias de todo tipo, lo que nos permite poder experimentar los nuevos productos tecnológicos de primera mano, tener todas nuestras preguntas técnicas resueltas al instante y poder informaros con todo el detalle que hemos hecho siempre. Sin ir más lejos, mientras escribo las últimas palabras de este artículo me encuentro a bordo de un Boeing 747-8 de camino a Estados Unidos para asistir a un importante evento de presentación tecnológica, del cual publicaremos más detalles en Geeknetic pronto.

El futuro además viene con fuerza, tenemos el WiFi 7 a la vuelta de la esquina, nuevos Snapdragon 8 Gen 2 que nutrirán los mejores smartphones de 2023, las nuevas CPUs de portátil de Intel y AMD que probablemente se presentarán en el CES de Las Vegas en enero de 2023, y con toda probabilidad la misma cita será aprovechada por NVIDIA para lanzar sus GPUs de portátil RTX 40. Estaremos allí para contártelo.

Tenemos además un gran equipo detrás tanto para reviews como para cubrir noticias, redactar guías y mucho más. Entre ellos me gustaría destacar a Javier Rodríguez, que como habréis visto es quien firma muchos artículos desde que se unió a nosotros en 2005, y a Antonio Delgado, redactor desde hace más de una década y coordinador editorial. No os perdáis tampoco los fantásticos artículos de Jordi Bercial, Juan Antonio Soto, Joan Vivas, Pablo López, Javier Romero y Edgar Otero que se esfuerzan a diario por contarnos todo lo que acontece.

Tanto si nos lees desde hace 20 años como si acabas de conocernos, te doy las gracias por hacerlo. No te imaginas las ganas que tenemos de satisfacer tu curiosidad, ayudarte con guías y mostrarte innovaciones tecnológicas increíbles tal y como se vayan produciendo.

No dudes en dejarnos un comentario aquí abajo, los leemos todos, y agradecemos cualquier cosa que quieras compartir con nosotros.

¡Y no te olvides del concurso! Hay en juego más de 5.500 euros en premios, tan solo por participar enviando un listado de productos que formen una configuración de PC.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!